1. プロジェクト概要:MICOとは何か?

MICO (AI Creative Co-pilot) は、「センス」や「感性」といった曖昧な要素をエンジニアリングで解き明かし、誰でもプロのような写真が撮れるようになるAIカメラアプリです。

多くの人が抱える「撮りたい思いはあるが、どう撮ればいいか分からない」という課題に対し、「スパイス(加工)」ではなく「骨格(構図)」へのアプローチで解決を試みました。そして撮影後には、その骨格を最大限に活かす「最適なスパイス(現像)」を自動で施します。

本記事では、MICOに搭載された全機能、技術スタック、そして構図から加工に至るアルゴリズムの全貌を詳細に解説します。

2. システムアーキテクチャ:ハイブリッドAIの設計

オンデバイスAI✖️クラウドAI

【オンデバイスAI (Edge)】

- 役割: リアルタイム構図スコアリング、物体検出、UIガイド表示、自動撮影

- 技術: TensorFlow Lite, ML Kit (Flutter)

- 性能: 推論速度 50-100ms/フレーム(オフライン動作可能)

- メリット: 通信遅延ゼロで、撮影の瞬間を逃しません。

【クラウドAI (Cloud)】

- 役割: 高精度な物体検出、詳細な美的スコア分析、コーチングコメント生成

- 技術: Python (FastAPI), YOLOv8, Gemini API

- メリット: サーバーの計算資源を使い、スマホでは不可能な深層学習モデルを実行します。

3. Core Tech ①:構図評価アルゴリズム(骨格の設計)

MICOの頭脳である「構図評価エンジン」の裏側には、感性を数値化する数学があります。

3.1 ハイブリッド構図評価システム (Ver 3.1)

「構図の良さ」を測るために、特性の異なる2つのアプローチを統合しています。

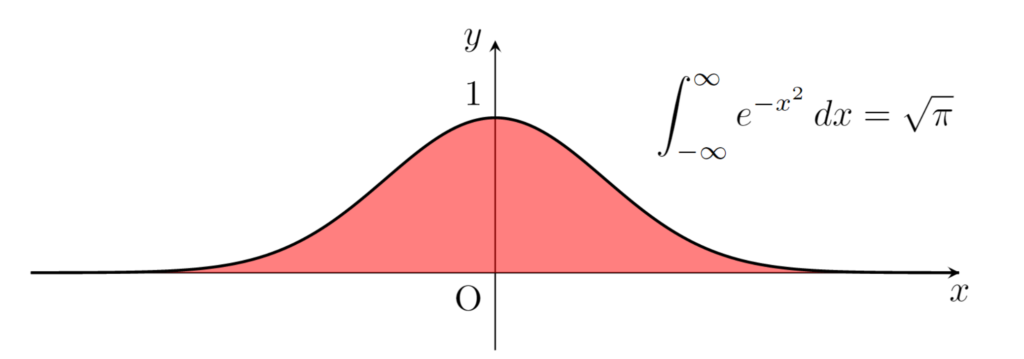

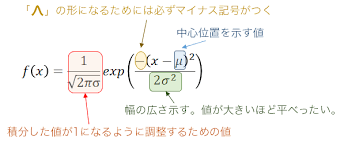

A. ガウス評価 (Gaussian Evaluation)

三分割法や黄金比など、「線や点」の構図に使用。

f(x) = a * e^(-(x-b)^2 / 2c^2)

理想的なライン上をピーク(1.0)とし、そこから離れるにつれてなだらかにスコアが減衰するヒートマップのような計算を行います。「完璧ではないが美しいズレ」を許容する人間的な評価です。

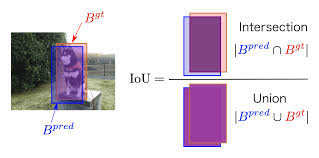

B. エリア評価 (IoU Evaluation)

ミニマリスト構図など、「領域配置」の構図に使用。

IoU = Area(A ∩ B) / Area(A ∪ B)

システムが推奨する理想領域と、実際の被写体領域の重なり具合(Intersection over Union)を計算し、バランスの良さを定量化します。

最終的なスコア算出には、MICO独自の評価哲学が反映されています。

A. 70/30の黄金比率

最終スコアは、構図の正確さだけでなく、写真としての美しさを加味して算出されます。

BaseScore = 0.7 * CompositionScore + 0.3 * AestheticScore

- Composition (70%): 上述のルール適合度。

- Aesthetic (30%): MobileNetV3(AVA Dataset 25万枚で学習)による美的品質評価(色彩、露出、ピント)。

B. 複合ボーナス(掛け算の魔法)

複数の構図ルールを同時に満たした場合(例:三分割法かつ対角線構図)、単純な足し算ではなく「掛け算」でボーナスを与えます。

FinalScore = BaseScore * (1 + Bonus_Factor)

- セカンダリールールが1つ成立: 1.15倍

- セカンダリールールが2つ成立: 1.30倍

C. 厳格化係数(Strictness Factor)

オンデバイスAIは処理を軽くするために簡易的な判定を行うため、スコアが甘くなりがりです。そこで、あえて減点補正をかけています。

- オンデバイス時: × 0.75 (厳しく判定し、ぬか喜びを防ぐ)

3.2 ルール競争エンジン (Rule Competition Engine)

プロの思考プロセスを再現するため、全32種類の構図ルール(被写体別22種+意図別10種)を実装。 これらがバックグラウンドで並列に評価され、スコアを競い合います。例えば「料理」を認識すれば StandardFoodRule が、「夜景」なら NightCityscapeRule が勝者となり、最適なガイドを動的に提示します。

この「競争」のメカニズムは、以下の数理モデルで定義されています。

【数学的定義:並列競争モデル】

// 1. 並列評価(Parallel Evaluation)

// 入力データ S に対して、全ルール R_i が優先度 P_i を計算

For each Rule R_i in Rules(32):

P_i(S) = R_i.calculatePriority(S)

// 2. プライマリー選定(Argmax Selection)

// 最もスコアが高いルールを「勝者」として選出

R_winner = argmax(P_i)

// 3. セカンダリー選定(Threshold Filtering)

// 閾値(60点)を超えるルールを補完候補として採用

R_secondary = { R_j | P_j >= 60.0 AND R_j != R_winner }

ここで、P_i(S) は、被写体認識率や環境光などのセンシングデータ S に基づいて算出される 0〜100 の動的スコア です。単純な条件分岐(if文)ではなく、この確率的な競争モデルを採用することで、複雑な撮影シーンにも柔軟に適応します。

3.3 主役度スコア (Protagonist Score)

画面内に複数の物体がある場合、何を「主役」とみなして構図を組むべきか。

MICOは以下の4要素の線形結合により、最も注目すべき被写体を特定します。

ProtagonistScore = 40 * S_size + 30 * S_pos + 20 * S_unique + 10 * S_conf

1. サイズスコア (Score(Size) / 40点)

画面占有率に基づくスコアです。単なる比例計算ではなく、視認性を考慮した段階的線形補間を用いて算出します。

Score = 40.0 if Ratio ≧ 0.25 (画面の1/4以上)

Score = 30.0 + (Ratio - 0.15) * 100 if Ratio ≧ 0.15

Score = 20.0 + (Ratio - 0.08) * 143 if Ratio ≧ 0.08

...

2. 位置スコア (Score(Pos) / 30点)

画面中央からの距離に基づく評価です。中央に近いほど高得点となります。

3. 単独性スコア (Score(Unique) / 20点)

周囲の物体密度が低い(孤立している)ほど、主役としての存在感が強いと判断し加点します。

4. コントラストスコア (Score(Conf) / 10点)

AI(ML Kit / YOLO)の検出確信度(Confidence)をそのままスコアとして反映します。

4. Core Tech ②:UXの制御工学

人間は機械のように静止できません。手ブレによる判定のブレを防ぐため、制御工学的なアプローチを取り入れました。

A. 安全領域 (Safe Zone 95%)

理想位置の算出において、画面端のノイズや歪みを排除するため、画面中央95%の有効領域 Z_safe を定義し、探索範囲に空間的な制約(Spatial Constraint)を設けています。

Z_safe = { (x, y) |

|x - W/2| <= 0.475 * W,

|y - H/2| <= 0.475 * H

}

これにより、被写体がフレームの極端な端にある場合の誤検出をフィルタリングします。

B. ヒステリシス制御 (Hysteresis Control)

単一の閾値による判定では、境界付近で判定が振動(チャタリング)してしまいます。

そこで、信頼度が閾値を下回っても 1.5秒間(T_hold)はロック状態を維持する、時間軸方向のヒステリシス制御を導入しました。

時刻 t におけるロック状態 L(t)は以下の論理式で決定されます。

L(t) = 1 if Confidence(t) >= Threshold

1 if (t - t_last_valid) <= 1.5s

0 otherwise

この「ダイナミック・ロックオン」機構により、撮影者が構図を微調整している間の意図しないガイド消失を防ぎ、吸い付くようなUXを実現しました。

5. Core Tech ③:画像処理・加工アルゴリズム(スパイスの設計)

MICOは「撮って終わり」ではありません。撮影時のコンテキスト(文脈)を引き継ぎ、その写真が最も輝くパラメータで自動現像を行う「AI Post-Production Engine」を搭載しています。

5.1 Context-Aware Grading(文脈適応型自動加工)

単一のフィルターを一律にかけるのではなく、「どの構図ルールで撮られたか」に応じて加工パラメータを動的に生成します。

- 例:夜景 (

NightCityscapeRule) の場合- ホワイトバランスをタングステン(青・紫寄り)へシフト。

- ネオンを強調するため、コントラストと彩度をブースト(+1.5)。

- 黒潰れを防ぐ微調整を行い、サイバーパンク風に仕上げます。

- 例:ポートレート (

FormalHeadshotRule) の場合- 肌色の均一化処理を優先。

- 瞳の輝き(Eye Enhancement)を強調し、背景ぼかしを最大化します。

5.2 ピクセルレベルの画像処理ロジック

手動編集機能においても、ライブラリ任せにせず独自のアルゴリズムを実装しました。

- シャープネス(畳み込み演算):3×3のカーネル行列を使用し、中央ピクセルを強調する畳み込みフィルタ(Convolution Filter)を適用。K = [ 0, -1, 0 ][ -1, 5, -1 ][ 0, -1, 0 ]

- ビネット効果(距離減衰):画像中心からのユークリッド距離dに応じて輝度を減衰させ、視線を中央に誘導します。Factor = 1.0 – ((d / max_dist) * Strength)

6. エコシステム機能

MICOは撮影体験全体を拡張する機能を備えています。

- AIチャット (Gemini API):撮影データ(構図スコア、被写体情報)をプロンプト化し、Gemini APIに送信。「もう少し右に寄ると背景が抜けます」といった具体的かつ自然な日本語アドバイスを生成します。

- AIマップ (Location Intelligence):Google Maps SDKを活用。ユーザーが高スコアを出した地点をマップ上に可視化し、「映える場所」を共有します。

- 全自動撮影 (Auto-Capture):「構図スコア > 85点」かつ「手ブレ安定」をオンデバイスAIが検知した瞬間、人間より速い反射神経でシャッターを切ります。

7. 技術スタック (Tech Stack)

Frontend (Mobile App)

- Framework: Flutter 3.1.0+ / Dart 3.1.0+

- On-Device AI: TensorFlow Lite (

tflite_flutter), Google ML Kit - Media Processing:

camera(Raw Stream),image(Pixel manipulation) - State Management: Provider (MVVM)

Backend (Cloud Infrastructure)

- API Server: Python 3.9+, FastAPI (Async), Uvicorn

- AI Models: Ultralytics YOLOv8 (Object Detection), PyTorch, TensorFlow

- Generative AI: Google Gemini API

- Cloud Media: Cloudinary (Image Transformation), Firebase Storage

Platform

- Database: Firebase Cloud Firestore (NoSQL)

- Auth: Firebase Authentication

8. AI精度検証:数値で見るMICOの実力

前章の技術スタックを用いて構築したMICOのAIモデルについて、定性的な「便利さ」だけでなく、定量的な「数値」に基づいた検証結果を報告します。

MICOの開発にあたり、「美的品質評価」「カテゴリー分類」「実用性(UX)」の3点において具体的なKPI(重要業績評価指標)を設定し、検証を行いました。

8-1. 美的品質評価:プロの感覚との誤差は「0.6点」

写真の「良さ」を10点満点で採点する美的品質評価モデル(Aesthetic Quality Assessment)の検証結果です。

- モデルアーキテクチャ: MobileNetV3-Large (転移学習 + ファインチューニング)

- 検証データ: AVA Dataset (Validation Set)

| 指標 | 目標値 | 実測値 | 判定 |

| MAE (平均絶対誤差) | 8.0%以下 | 6.37% (0.0637) | ✅ 達成 |

| 推論速度 (TFLite) | 50ms以下 | 6.27ms | ✅ 達成 |

ここで注目すべきは MAE 0.0637 (6.37%) という数値です。

これは、プロの写真家が「8.0点」とつけた写真に対し、AIの予測が平均して「7.4点〜8.6点」の範囲(誤差±0.6点)に収まることを意味します。

主観が混じる「美しさ」の評価において、誤差を6%台に抑えられたことは、AIが人間の感性を高いレベルで獲得できたことを示唆しています。

8-2. カテゴリー分類:なぜ「Top-3精度」で92%なのか

ユーザーが何を撮ろうとしているかを判断する物体認識モデルの精度です。

- 検証データ: COCO Dataset + 独自収集データ (計6,000枚規模)

| 指標 | 実測値 |

| Top-1 精度 (1位正解率) | 65.51% |

| Top-3 精度 (上位3位正解率) | 92.20% |

正直に申し上げると、最も確率の高い1つの答えを当てる「Top-1精度」は65.51%であり、完璧とは言えません(例:カレーとシチューの誤認など)。

しかし、MICOでは評価指標として Top-3精度 (92.20%) を採用しました。これには明確なエンジニアリング上の意図があります。

MICOの目的は「名前当てゲーム」ではなく「最適な構図ガイドの提示」です。

例えばAIが「1位:ビーフシチュー、2位:カレー」と迷ったとしても、両者に適用される構図ルール(料理撮影用の対角線構図など)は共通しています。

上位3つの候補の中に正解が含まれていれば、ユーザーには「正解のガイド」が提供されるため、実用上の問題はないと判断しました。

8-3. UXを守るための「魔法の数字」

AIが出した生の数値をそのまま使うと、ユーザー体験(UX)を損なう場合があります。そこで、私たちは実装コード内にいくつかの調整パラメータ(係数)を組み込みました。

① 厳格化係数:0.75

オンデバイス(スマホ側)の軽量モデルは、処理能力の限界から評価が甘くなる傾向があります。サーバー側の高精度モデルとのギャップを埋めるため、スマホ側の算出スコアには一律0.75倍の補正を掛けています。

// オンデバイス評価の厳格化ロジック

double strictScore = rawScore * 0.75;

// 例: 生スコア80点 → 表示スコア60点

これにより、「撮影時は90点(高評価)だったのに、後で詳細分析を見たら70点だった」というユーザーの失望(ぬか喜び)を防ぎ、信頼性を担保しています。

② Persistence(持続検出):2.0秒

リアルタイム検出において、AIの判断がフレームごとに切り替わると画面のガイドが点滅し、ユーザーのストレスになります。

そこで、信頼度40%〜69%の中確度検出においては、2.0秒間の継続検出を条件とする「Persistence制御」を実装しました。

このバッファを持たせることで、誤検出による画面のチラつきを排除し、落ち着いて撮影できる体験を実現しました。

9. まとめ

MICOは、「オンデバイスの即時性」と「クラウドの知性」、そして「ピクセル単位の画像処理」を融合させた総合的な撮影支援システムです。

「構図(骨格)」を整え、「加工(スパイス)」で仕上げる。

この一連のプロセスをエンジニアリングすることで、ユーザーの「撮りたい」という想いを、確かな「作品」へと昇華させます。

(執筆:AIシステム開発学科 / 梁 智徳)

コメント